Per chi si fosse perso un po’ di passaggi, facciamo un passo indietro, e analizziamo un po’ il background.

Conosciamo oramai molto bene le esigenze di un mondo che viaggia spedito verso la digitalizzazione dei servizi, e seppur a velocità un po’ diverse, notiamo che si tratta di un processo che via via si estende a tutti i settori (e a tutti i paesi).

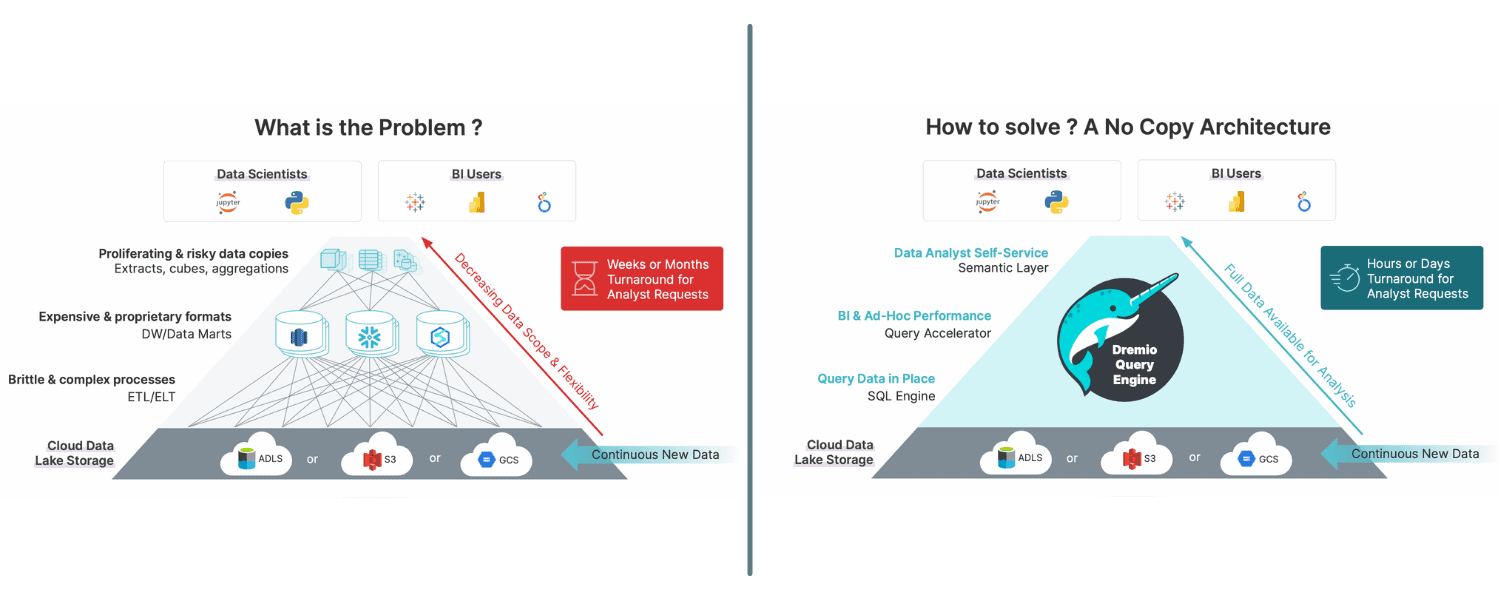

Ciò che ha accomunato in questi anni le aziende è stata la proliferazione dei dati, e la presa di coscienza dell’enorme valore informativo che rappresentano. Sappiamo però bene che esiste una bella differenza tra dato e informazione. Avere a disposizione enormi quantità di dati eterogenei e riuscire a non “disperderli” attraverso strutture dati di vario genere non è sufficiente per sfruttarne appieno il valore. I Dati Grezzi, a seguito del processo di storage, devono infatti essere opportunamente indicizzati, processati, arricchiti per essere realmente informativi. E, soprattutto, devono essere messi correttamente a disposizione degli analisti.

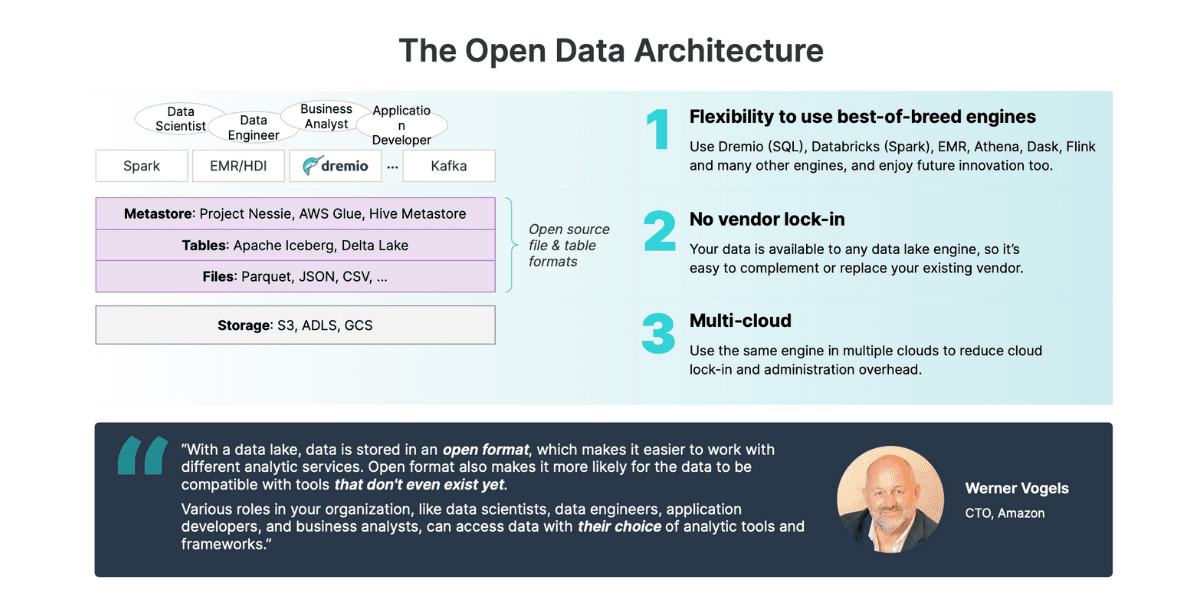

A tutto ciò fa da sfondo la difficoltà nel far combaciare esigenze tecniche e di business, ovvero trovare una “via di mezzo” tra soluzioni performanti e scalabili dal punto di vista del Data Engineer, e soluzioni che semplifichino l’accesso ai dati da parte dei Consumer (analisti, data scientist, ecc..). Tutto questo, naturalmente, cercando di non impattare in modo eccessivo sui costi, che a seconda dello scenario, possono crescere di molti ordini di grandezza.

L’evoluzione delle Architetture

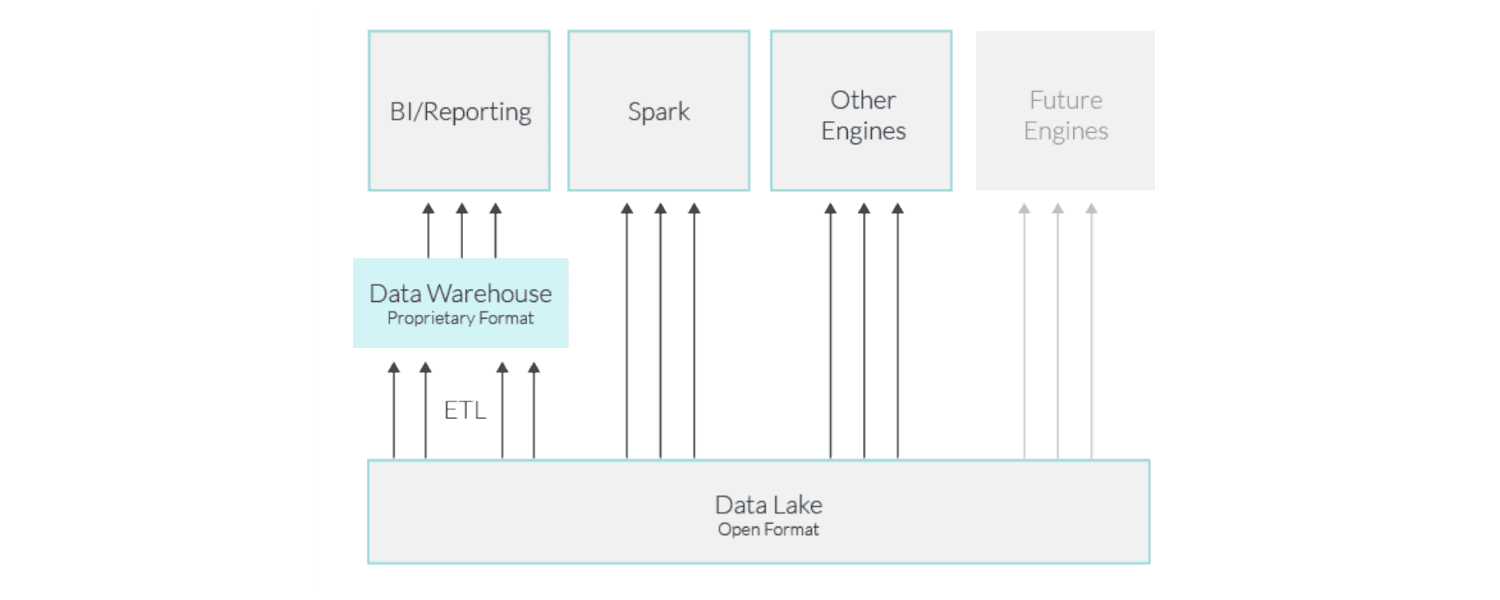

Abbiamo visto negli anni un’evoluzione nelle modalità di gestione del dato: dai primi Data Warehouse siamo passati ai Data Lake, e abbiamo assistito allo sviluppo di svariate tecnologie e approcci di estrazione, manipolazione e interrogazione dei dataset.

I data warehouse rappresentano una soluzione per immagazzinare, gestire ed elaborare in modo sicuro i dati, con prestazioni ottimizzate a seconda dei casi d’uso, come reporting e business intelligence (BI). In passato, le organizzazioni centralizzavano i dati in un data warehouse con l’intenzione di fornire una singola fonte (SSOT) per analisi. I data Warehouse forniscono prestazioni elevate per i dati strutturati con metodi come l’archiviazione e l’ottimizzazione delle query e il caching delle tabelle usate di frequente.