Conclusione

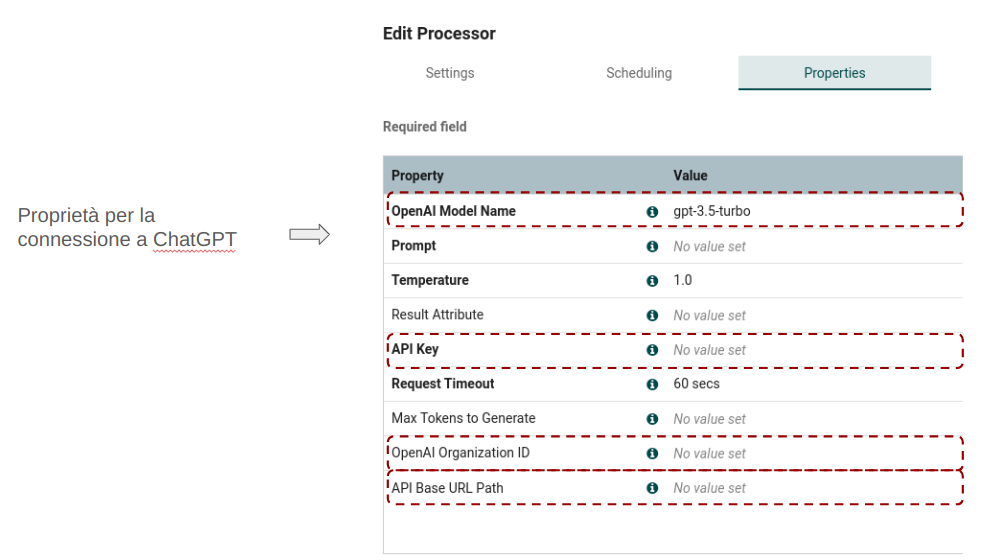

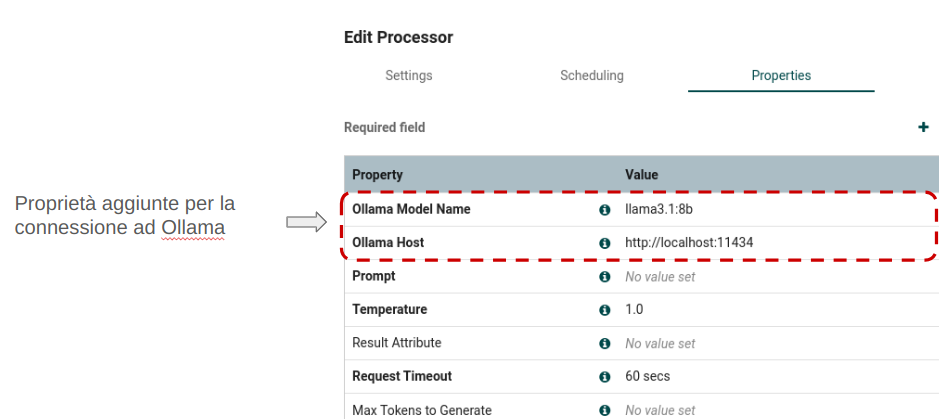

L’implementazione di un processor che utilizza Ollama dimostra come sia possibile costruire in Nifi soluzioni anche attraverso l’uso di modelli di LLM locali.

Questo approccio è particolarmente interessante per aziende che richiedono maggiore controllo sui propri dati o operano in ambienti con connessioni internet limitate e ove le esigenze possano essere soddisfatte con l’utilizzo di tale tipologia di strumenti.

Grazie al supporto per i processor scritti in Python introdotto in NiFi, la customizzazione è stata abbastanza agevole.

E’ possibile estendere ulteriormente quest’ultima modificando anche i processor che generano i vector embedding ampliando così lo spettro delle integrazioni possibili su tale ambito avendo quali target OpenSearch, o altri vector db.

Avere a disposizione il prompt che utilizza Ollama per le risposte e il vector embedding ci consente di pensare alla implementazione di sistemi RAG su tecnologia interamente opensource e locale.

Tali implementazioni utilizzerebbero Nifi ed il suo ecosistema per l’implementazione di tutta la catena di acquisizione del dato e un motore locale sia per LLM che per la generazione del vector embedding.