Come utilizzare efficacemente il vector embedding

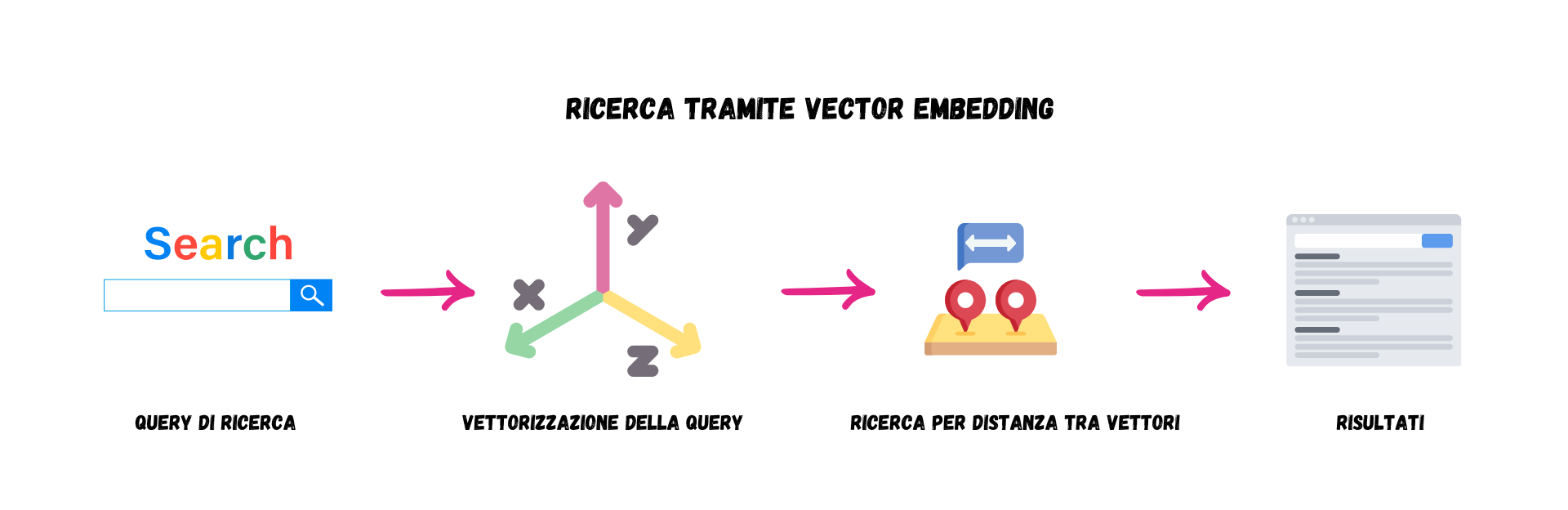

Per utilizzare efficacemente la ricerca vettoriale, i dati devono essere trasformati in vettori tramite modelli di embedding. È importante distinguere tra i modelli statici di embedding, che generano una rappresentazione fissa per ogni parola, e modelli contestuali che generano embedding dinamici basati sul contesto in cui la parola appare.

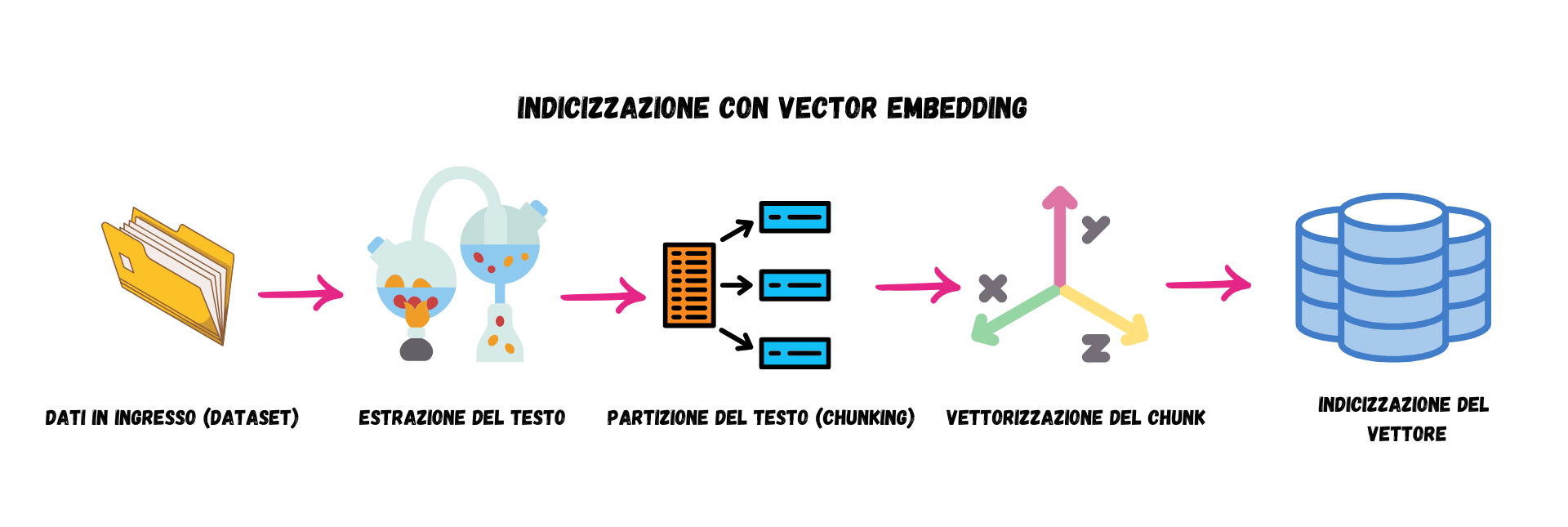

Nel caso di testi lunghi, che potrebbero superare la capacità di un modello di elaborazione del linguaggio naturale, il testo viene suddiviso in ‘chunk’ o segmenti, che vengono poi trasformati in vettori separati. Questo processo migliora l’efficienza e la precisione della ricerca.

Una volta trasformati in vettori, i dati vengono memorizzati in un database vettoriale o in un motore di ricerca che supporta la ricerca semantica. OpenSearch è una delle soluzioni che permettono l’archiviazione e l’indicizzazione di vettori per effettuare ricerche basate sul significato. Inoltre, supporta la ricerca ibrida, combinando la ricerca per parole chiave con quella vettoriale, migliorando così la capacità di recupero delle informazioni.

Sotto una immagine riassuntiva dei passi necessari per la indicizzazione tramite vector embedding.