1.1 Dremio

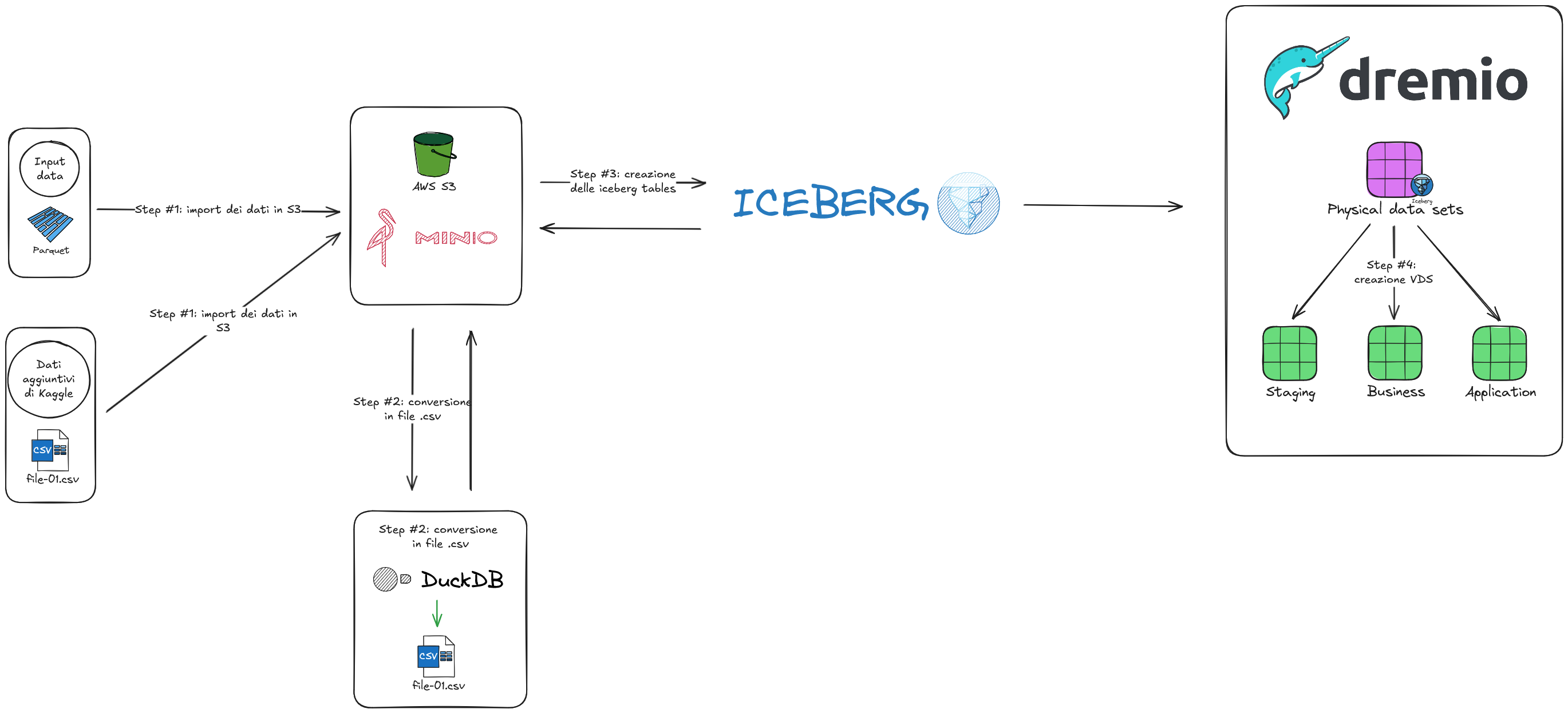

Dremio è una piattaforma data lakehouse che esegue query SQL sui data lake senza trasferire i dati in warehouse tradizionali. Con il suo motore ottimizzato, accelera le analisi riducendo tempi e costi.

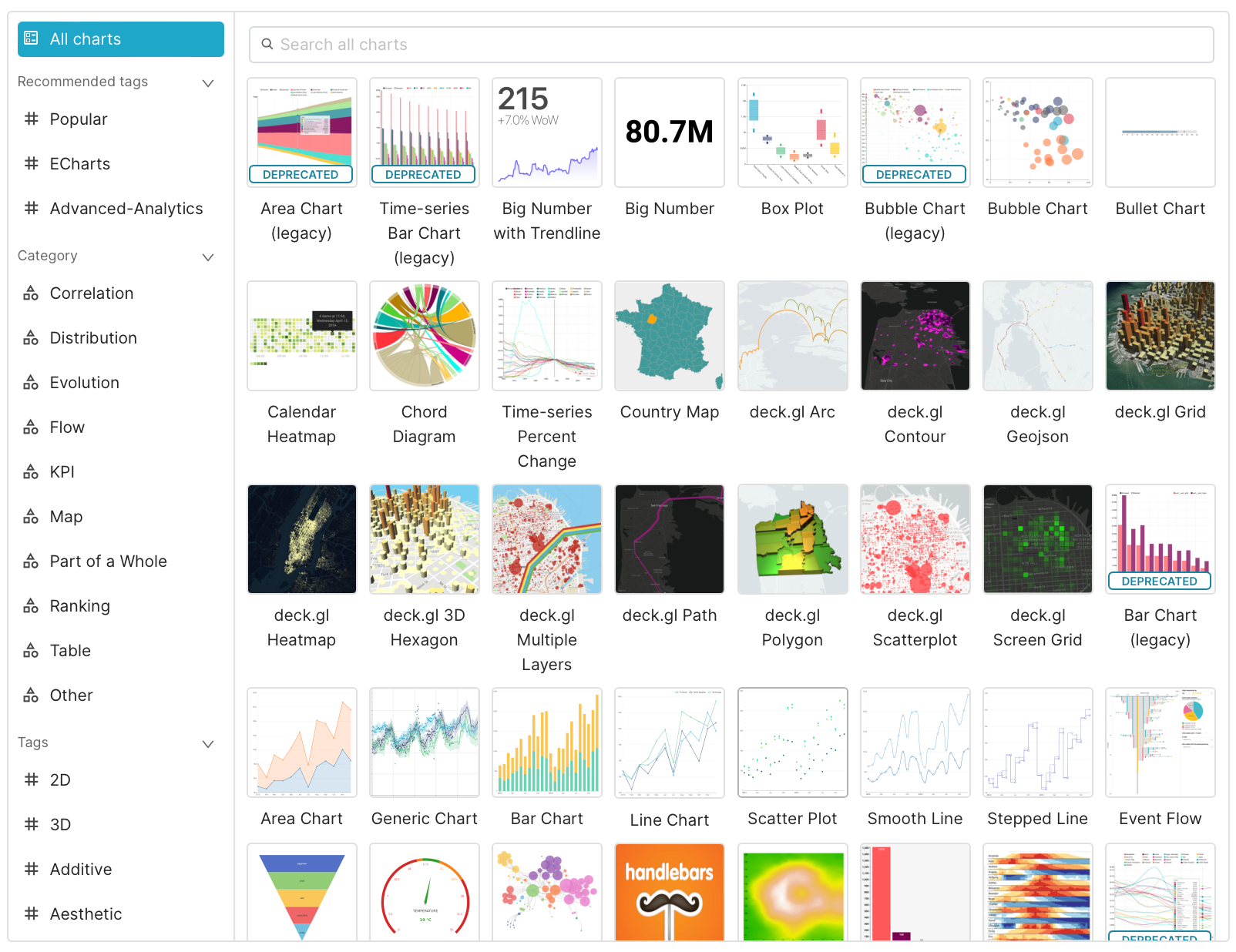

Supporta diverse fonti dati (S3, Azure Data Lake, database relazionali) senza ETL complessi, offrendo virtualizzazione e integrazione con BI tools come Tableau, Power BI e Superset, rendendolo ideale per analisi in tempo reale di grandi volumi di dati.

L’integrazione con Apache Iceberg è un punto di forza, offrendo versioning di dati e metadati tramite file catalog per tracciare le modifiche agli schemi. Questo semplifica la gestione del lakehouse, rendendo Dremio particolarmente efficace per dataset scalabili.