Se comprendiamo come funziona l’universo, in qualche modo lo controlliamo.

(Stephen Hawking)

Al giorno d’oggi sentiamo sempre più parlare di flussi di dati di svariati tipi, da quelli generati dai clienti che utilizzano applicazioni Web o effettuano acquisti online, dati di transazioni finanziarie, eventi su piattaforme per videogiochi, informazioni provenienti da social network e altro ancora.

L’intero ecosistema digitale che domina il business moderno è il principale produttore di dati. Parliamo di una quantità enorme di informazioni generate giornalmente, in un vero e proprio flusso.

A fronte di tutto ciò, le esigenze delle aziende moderne si stanno gradualmente modificando verso un tipo di analisi in tempo reale, in grado di “catturare” ed estrarre informazioni di valore dal dato.

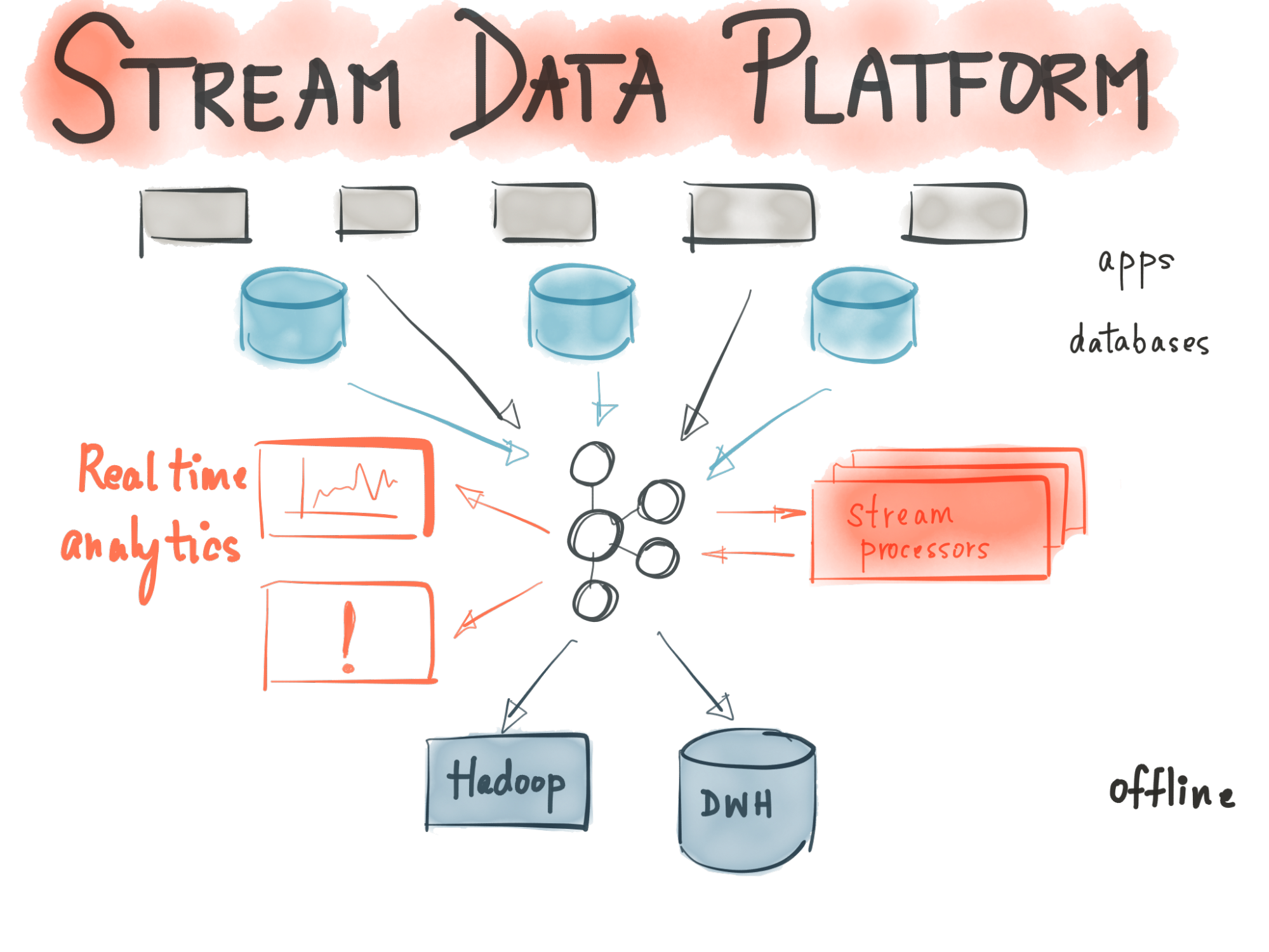

Partiremo da questa esigenza per descrivere il concetto di Data Streaming, un approccio che nasce appositamente per risolvere la complessità dell’analisi del dato in real-time, attraverso soluzioni che garantiscano robustezza, efficienza e scalabilità.

Data Streaming: definizione e casi d’uso

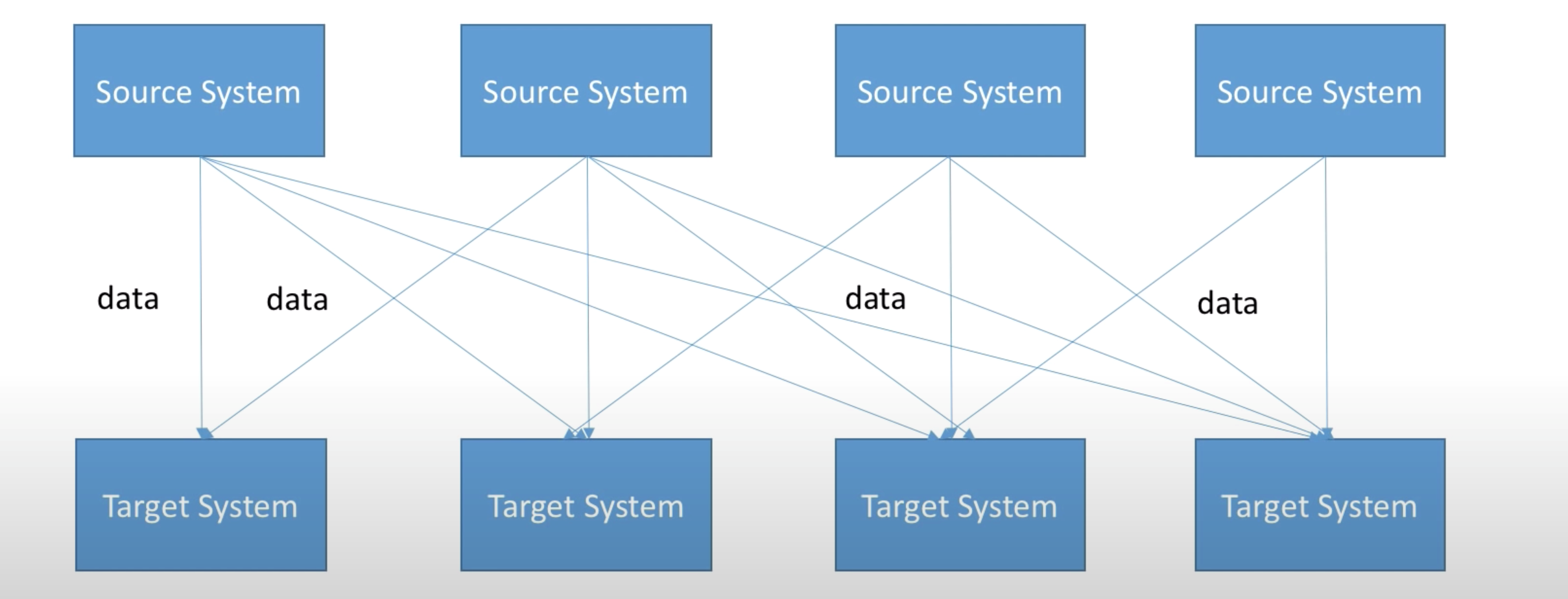

Il Data streaming, anche conosciuto come Event Streaming o Stream Data Processing, è un termine che identifica la capacità di un sistema di intercettare molteplici flussi (streams) di dati ed effettuare una serie di operazioni su di essi. Rispetto alla modalità “tradizionale” di gestione dati, questo approccio consente di evitare il processamento asincrono (batch processing), evitando quindi di dover caricare i dati in strutture apposite per una successiva analisi.

Per comprendere meglio il concetto possiamo descrivere alcuni casi d’uso attuali.

Pensiamo ad esempio al caso dell’industria 4.0: come è possibile monitorare in tempo reale i dati provenienti dalle migliaia di sensori montati sulle macchine?

Oppure pensiamo al contesto della fraud detection: come possiamo sviluppare un sistema che consenta di monitorare dati di traffico in modo tanto efficiente da permetterci di identificare frodi in tempi brevi?

E sempre in ambito finanziario, come può una società tenere sotto controllo le variazioni del mercato azionario in tempo reale, così da elaborare la possibilità di rischio e riequilibrando automaticamente i piani finanziari in base in base alle fluttuazioni dei prezzi delle azioni?

Qualunque sia la situazione di riferimento, è necessario avvalersi di strumenti in grado di gestire il flusso dati, cercando di ottenere il massimo valore dal dato in tempo reale.