Distinguere open vero da marketing

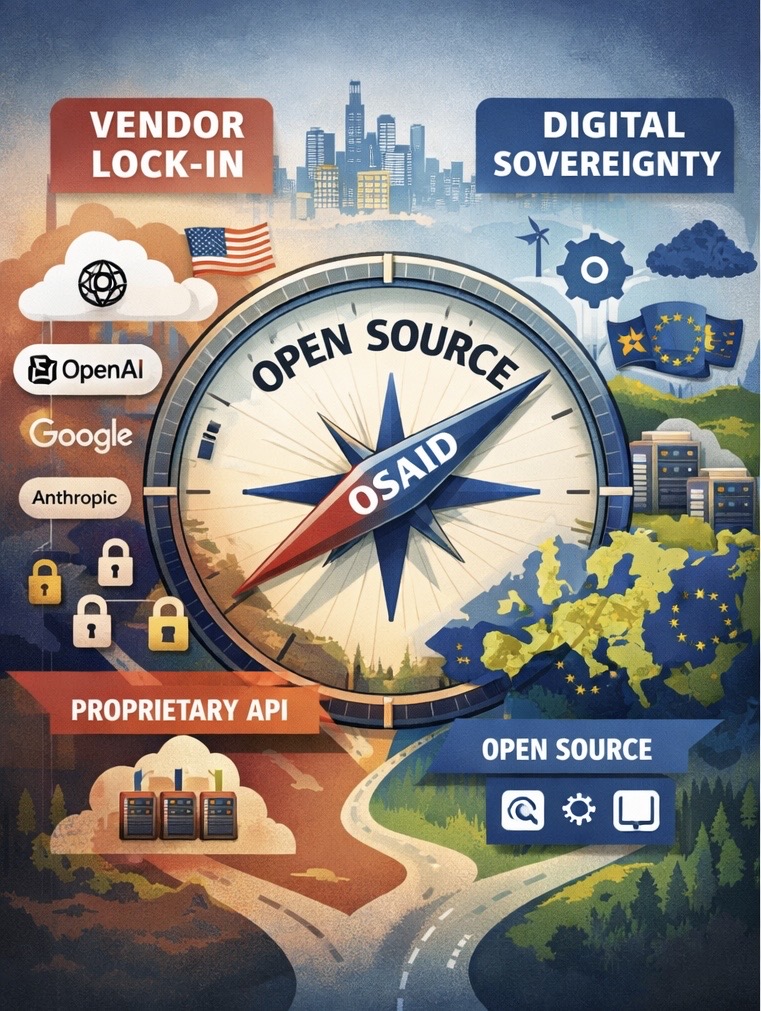

LLaMA di Meta: pesi aperti, ma licenza con restrizioni commerciali che la Open Source Initiative rifiuta di certificare come vera open source. I gpt-oss di OpenAI rilasciati ad agosto 2025: licenza Apache 2.0 sui pesi (open-weight), ma senza accesso ai dati di training completi necessari per riprodurre il modello. Entrambi violano l’OSAID.

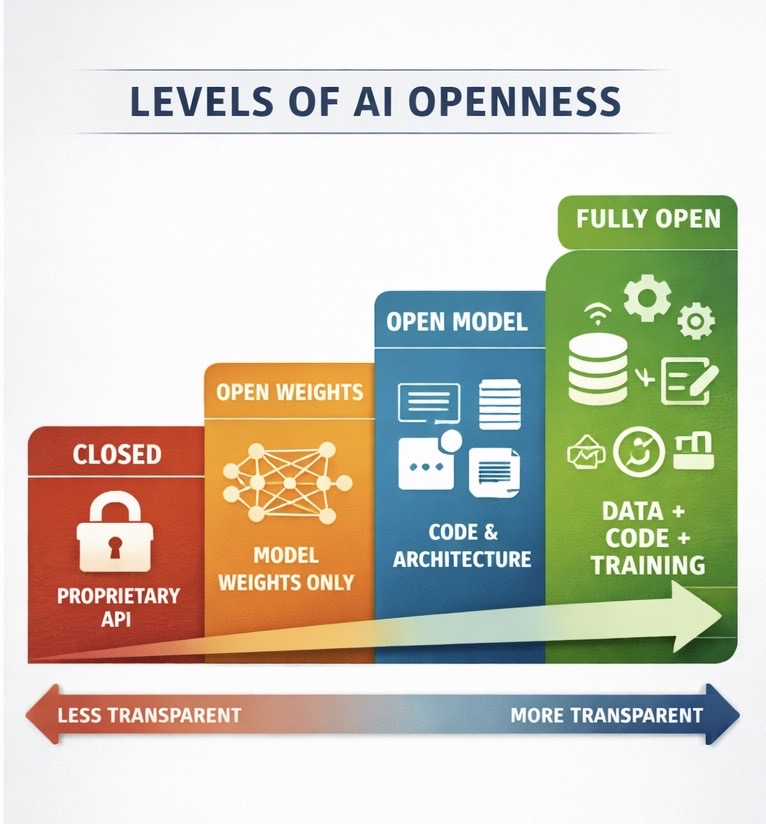

L’OSAID richiede: pesi disponibili, architettura documentata, dati di training accessibili o riproducibili, codice di addestramento, licenza permissiva. La maggior parte dei modelli commercializzati come “open” fallisce almeno due di questi criteri. Questo fa la differenza tra avere vera ownership o essere ostaggio di scelte altrui.

Esempio pratico: costruisci un servizio sanitario pubblico su LLaMA. Se le voci su un cambio di strategia di Meta si concretizzassero, ti ritroveresti con tecnologia legacy che nessuno sviluppa più. Oppure costruisci su gpt-oss, sapendo che OpenAI ha scritto esplicitamente nel comunicato di rilascio: “Stiamo valutando se i punti di forza di questi modelli giustifichino investimenti futuri in questa direzione.” Dipendi da una valutazione futura che non controlli.

OSAID comunque non va inteso come un requisito binario o un dogma ideologico. Nell’AI l’apertura non è un interruttore acceso/spento, ma uno spettro. OSAID descrive il punto di massima verificabilità e riproducibilità, utile come riferimento e direzione, non come barriera all’adozione. Ciò che conta è distinguere tra chi ha limiti oggettivi ma una traiettoria di apertura chiara e chi usa l’etichetta ‘open’ come puro marketing.