“Sono come il fiume che scorre”

Paolo Coelho

L’elaborazione di un flusso di dati può essere rappresentata nell’immaginario collettivo come un fiume che scorre verso la sua foce. Infatti, allo stesso modo in cui l’acqua scorre attraverso un fiume, così fanno i pacchetti di informazioni nel flusso infinito della loro elaborazione in tempo reale.

Nello scenario tecnologico moderno si trovano molti esempi in cui questo “flusso” di dati è rappresentato. Pensiamo ad esempio ai dati provenienti da sensori montati su macchinari industriali, le attività genarate dagli utenti sui social, o ancora le informazioni geospaziali rilevate in tempo reale dalle autovetture. Sono solo pochi esempi che esprimono come il mondo reale sia un continuo produttore di dati, aggiornati nell’ordine dei millisecondi.

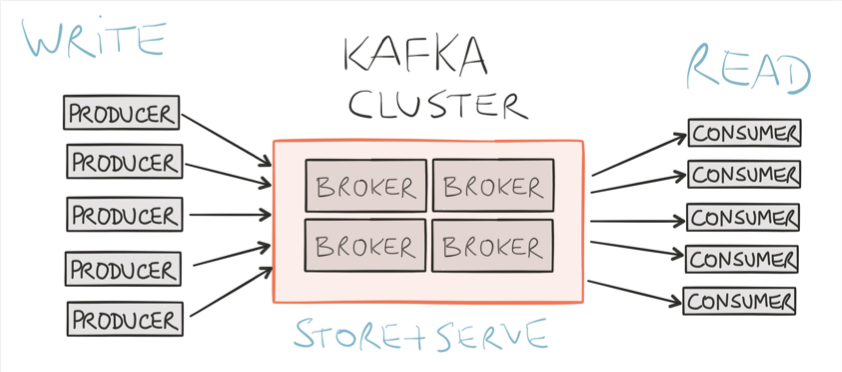

Il Data Streaming, o Stream Processing, è l’approccio che nasce allo scopo di permettere l’elaborazione di questi “dati in movimento”.